Intelligenza artificiale e sfruttamento: quando la tecnologia diventa un’arma contro donne e bambine

Traduzione del post di Coalition Against Trafficking In Women

Negli ultimi anni l’intelligenza artificiale (IA) è entrata in modo sempre più profondo nelle nostre vite. Se da un lato se ne esaltano gli aspetti innovativi e le promesse di progresso, dall’altro non possiamo ignorare i rischi legati a una tecnologia in rapida evoluzione, spesso lanciata sul mercato senza regole chiare né responsabilità.

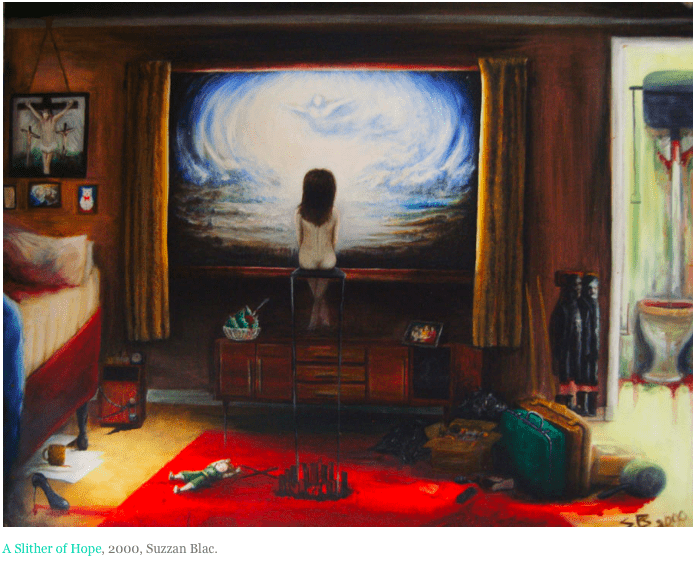

Dietro l’immagine patinata di compagne virtuali e chatbot sempre disponibili, si nasconde una realtà inquietante: l’IA viene già utilizzata per normalizzare abusi, alimentare fantasie misogine e produrre materiale di sfruttamento sessuale minorile (CSAM). Le cosiddette “AI girlfriends” vengono presentate come “compagne” personalizzabili, programmate per offrire disponibilità illimitata e affetto. Ma parlare di consenso reciproco in questo contesto è impossibile. Queste tecnologie alimentano aspettative distorte e mercificate sull’intimità, permettendo agli utenti di esercitare comportamenti di controllo o di abuso senza conseguenze. Molte app, infatti, non solo consentono ma incoraggiano scenari sessualmente espliciti, degradanti o violenti. L’assenza di un partner reale cancella ogni freno sociale, creando un terreno fertile per la desensibilizzazione e la trasposizione di questi comportamenti nelle relazioni umane.

Uno degli usi più devastanti dell’IA riguarda il materiale di abuso sessuale su minori. Sistemi in grado di produrre immagini iperrealistiche creano bambini che non esistono, rendendo difficile perseguire i colpevoli: le forze dell’ordine rischiano di finire per inseguire vittime inesistenti, mentre i bambini reali restano non protetti. Ancora più inquietante è l’uso delle tecnologie deepfake, strumenti in grado di spogliare foto di minori reali o di sovrapporre il volto di un bambino a materiale pornografico adulto. Il risultato è un trauma incalcolabile per le vittime e la pericolosa normalizzazione dell’abuso sessuale.

Un caso emblematico è quello di Stable Diffusion, modello di IA open-source scaricabile e utilizzabile senza restrizioni. Addestrato originariamente su enormi dataset contenenti pornografia, misoginia e CSAM, continua a riprodurre contenuti dannosi. Anche se le versioni più recenti hanno bandito questo materiale dai dataset, la natura open-source permette a chiunque di adattare i sistemi e “ri-addestrarli” con le proprie immagini. Un rapporto di Internet Watch Foundation del 2023 ha documentato oltre 20.000 immagini generate con IA pubblicate in un solo mese in un forum del dark web: più della metà erano criminali e il 99,6% raffigurava bambine.

Negli Stati Uniti la creazione e diffusione di CSAM generato dall’IA è illegale. Ad agosto 2025, 45 stati hanno già approvato leggi specifiche per criminalizzare questo fenomeno, con oltre la metà delle norme approvate soltanto tra il 2024 e il 2025. Ma mentre la normativa si evolve, cresce anche l’ingegnosità dei criminali. Le forze dell’ordine faticano a stare al passo con una tecnologia che corre più veloce delle leggi.

Contrastare lo sfruttamento sessuale abilitato dall’IA richiede uno sforzo collettivo. Come cittadinə, possiamo sostenere organizzazioni che combattono lo sfruttamento digitale, pretendere che le aziende tecnologiche adottino linee guida etiche solide prima di immettere prodotti sul mercato e spingere chi governa a varare leggi chiare, applicabili e urgenti. Le nostre azioni oggi determineranno se l’intelligenza artificiale diventerà uno strumento di emancipazione e diritti, o un’arma di sfruttamento e violenza.

Fonti utilizzate

CameraForensics. A Guide to AI-Generated CSAM for Investigators of Online Exploitation. 18 Aug. 2024, www.cameraforensics.com/blog/2024/11/18/a-guide-to-ai-generated-csam-for-investigators-of-online-exploitation/#what-are-the-dangers-of-ai-generated-csam.

Downing, S. The Dark Reality of Stable Diffusion. CameraForensics, 8 Feb. 2024, www.cameraforensics.com/blog/2024/02/08/the-dark-reality-of-stable-diffusion/.

Enough Abuse. State Laws Criminalizing AI-Generated or Computer-Edited CSAM. 2025, enoughabuse.org/get-vocal/laws-by-state/state-laws-criminalizing-ai-generated-or-computer-edited-child-sexual-abuse-material-csam/.

Internet Watch Foundation. How AI is Being Abused to Create Child Sexual Abuse Imagery. 2023, www.iwf.org.uk/media/q4zl2ya/iwf-ai-csam-report_public-oct23v1.pdf.

Kuznetsova, M. “HER Artificial Voice, His Real Aggression? Can AI Girlfriends Bring a New Wave of Women’s Objectification?” Harvard Kennedy School – Carr Ryan Center for Human Rights, 7 Mar. 2025, www.hks.harvard.edu/centers/carr-ryan/our-work/carr-ryan-commentary/her-artificial-voice-his-real-aggression-can-ai.

Schramowski, P., Brack, M., Deiseroth, B., and Kersting, K., editors. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). 2023, arxiv.org/abs/2211.05105.

Thorn. AI-Generated Child Sexual Abuse: The New Digital Threat We Must Confront Now. 13 Aug. 2025, www.thorn.org/blog/ai-generated-child-sexual-abuse-the-new-digital-threat-we-must-confront-now/.